Ce thibillet fait partie d’une série de réflexions sur la crise du Corona virus et le passage d’une partie de mes cours en présentiel à une version en ligne.

Jamais les étudiant(e)s n’ont autant triché qu’à la fin de ce semestre d’étude. Le confinement a nécessité que les examens finaux soient organisés à distance, ce qui a visiblement permis des fraudes de grande ampleur. Même si beaucoup d’universités demandent aux étudiants de signer une déclaration sur l’honneur, cela n’a pas empêché une proportion inhabituelle de triche. Cela pose d’abord la question de la motivation à tricher. Les raisons traditionnelles – c’est-à-dire hors confinement – sont soit l’impréparation, soit le goût du jeu dangereux, la triche étant vue comme un raccourci moral. Mais dans ces temps de pandémie, on constate aussi que des étudiant(e)s « non traditionnellement tricheurs » recourent à cette stratégie pour améliorer leurs notes. En effet, dans beaucoup de pays, les employeurs potentiels demandent un détail des notes obtenues dans les études avant de recruter. Les étudiant(e)s actuels craignent alors que leurs notes « en confinement » soient trop basses pour leur futur emploi, ou qu’elles ne leur permettent pas de s’inscrire dans certains parcours de spécialisation. Cela est exacerbé par le fait que dans certaines filières, les professeurs semblent ignorer les contraintes de travail à distance, et ils demandent la mémorisation de quantité de données en un temps très limité : on quitte alors le domaine de l’apprentissage pour celui du gavage. Ce thibillet ne cherche pas à comprendre – encore moins à excuser – les comportements de triche en ligne, mais plutôt à réfléchir sur les manières d’éviter la triche lors des examens à distance.

Plusieurs populations concernées

L’examen final confronte différentes populations dont les intérêts ne sont pas obligatoirement alignés.

- Il y a d’abord les tricheurs, qui ne sont pas forcément une population homogène, comme indiqué dans les motivations données précédemment.

- Il y a ensuite les non tricheurs, qui ne devraient pas être pénalisés par les stratégies anti-fraude. En effet, le fait de multiplier les contrôles (surveillance par caméra, pare-feu pour empêcher d’accéder à certains sites) conduit automatiquement à des blocages technologiques. En conséquence, un(e) étudiant(e) de bonne foi peut être pénalisé par un système de surveillance qui l’empêche de passer son examen dans de bonnes conditions.

- Il faut aussi penser aux surveillants : ils sont officiellement chargés de vérifier que les participants ne trichent pas, mais leur capacité d’action est limitée : autant il est possible de dire que l’étudiant X a été aidé par une personne qui est apparue dans le champ de la caméra, autant il est impossible de dire ce que regardait l’étudiante Y sur son écran : était-ce l’examen, ou bien une discussion Whatsapp d’un groupe de triche ?

- Il y a enfin le concepteur de l’examen en ligne, qui a ses propres contraintes et qui doit faire des choix d’optimisation (que nous allons détailler).

Les 4 lois d’un bon examen

On peut essayer d’énoncer la recette magique, ou la boussole morale, de la personne chargée de concevoir un examen en ligne, en suivant un chemin analogue aux 3 lois de la pédagogique. Dans le cas des examens en ligne, ces 4 lois seraient, par ordre décroissant d’importance :

- Les étudiant(e)s non tricheurs ne doivent pas souffrir du système anti triche mis en place ;

- Les étudiant(e)s tricheurs doivent être empêchés, ou fortement limités, dans leur capacité à tricher, sans contrevenir à la règle 1 ;

- L’examen doit être facile à corriger pour le professeur, sans contrevenir à la règle 1 ou 2 ;

- Enfin, sans contrevenir aux règles 1, 2 et 3, le rôle des surveillants devrait devenir accessoire. Idéalement, il n’y aurait plus besoin de surveiller. C’est un peu comme la notion d’efficience forte des marchés financiers : dans un examen correctement conçu, peu importe qu’un(e) étudiant(e) puisse contacter d’autres personnes, car en les contactant, il ou elle n’obtiendra pas plus d’avantages qu’en faisant le travail seul(e).

La tension principale : temps vs. personnalisation

Pour la personne qui conçoit un examen, une des variables importantes est le temps. Il s’agit non seulement du temps de conception et de test de l’examen en amont, mais aussi le temps de correction / notation de l’examen après coup.

- À un extrême de cette tension, on peut situer le QCM (questionnaire à choix multiple) : pour un temps de préparation qui n’est pas trop élevé, on a un temps de correction finale très réduit. C’est l’idéal pour le professeur qui ne veut pas y passer trop de temps.

- À l’autre extrême, on a l’examen avec des questions ouvertes qui nécessitent une dissertation de la part de l’étudiant. Le terme dissertation est au sens large : ce n’est pas seulement « pensez-vous que l’Homme est bon », cela peut aussi être « compte-tenu de la situation présentée ci-dessus, dites ce que vous recommanderiez ». Dans ce cas, il faut du temps pour concevoir l’examen, mais probablement moins que dans le cas d’un QCM ; en revanche, la correction / notation nécessitent de lire attentivement tout ce qui a été écrit, voire lire entre les lignes. En effet, même si l’étudiant n’a pas forcément utilisé un mot-clé important, il/elle a pu néanmoins comprendre la notion, et seule une analyse fine de sa réponse permettra de juger si la notion est maîtrisée ou juste apprise par cœur sans réelle compréhension. Dans ce deuxième extrême, la correction est donc extrêmement personnalisée, car l’étudiant nous permet de « rentrer dans sa tête ».

Cette problématique temps vs. personnalisation va donc devenir cruciale pour beaucoup de professeurs quand il s’agit de concevoir un examen.

Il y a aussi des conflits d’intérêts qui apparaissent, sous la forme du temps que le professeur est prêt à consacrer aux examens. Prenons l’exemple des étudiant(e)s qui ont été mis en échec à l’examen : dans la plupart des institutions, cela conduit à un examen de rattrapage. Or cet examen représente un surplus de travail pour le professeur, pour lequel il ne touche généralement pas de rémunération spécifique. Donc le professeur devra concevoir un deuxième examen pour une poignée d’étudiants, mais il ne devra pas faire ce travail si tous les étudiant(e)s ont passé l’examen avec succès. On peut imaginer que dans certains cas, le professeur aura tendance à arrondir la note d’examen pour éviter un rattrapage – ou encore, qu’il fera un rattrapage facile à concevoir, rapide à noter, et facile à réussir. Cette problématique de temps additionnel sera exacerbée par le fait que cela peut ne concerner que quelques étudiant(e)s : qui voudrait rédiger un examen de rattrapage de 3h juste pour une personne ?

Réflexions et solutions pour un examen à distance sur ordinateur

Après ces réflexions générales, regardons maintenant différentes solutions techniques d’examens en ligne. Pour l’illustration, nous prendrons le système d’examens intégré à BlackBoard, non seulement parce que cette solution est très répandue dans le monde académique, mais aussi parce qu’elle offre beaucoup de possibilités dans la construction des examens par ordinateur.

La mauvaise solution : les QCM

[Par QCM, on entend ici non seulement les questions à choix multiples (QCM) – avec une seule réponse possible – mais aussi, en généralisant, les questions à réponses multiples (QRM) – où il y a plusieurs réponses correctes à sélectionner]

Bien qu’apparaissant comme une solution facile, les QCM/QRM ne sont pas une bonne idée pour éviter la triche à distance, pour plusieurs raisons détaillées ci-dessous.

- Le mélange des réponses ne marche pas.

Blackboard permet de mélanger l’ordre des réponses au sein d’une question, dans l’espoir de réduire la « collecte latérale d’informations » de la part des étudiant(e)s. Mais hélas, certains étudiants tapent très vite sur leur clavier : quand ils communiquent entre eux pour s’échanger les bonnes réponses, cela ne change rien qu’ils disent « réponse b. », ou « le bon montant, c’est 12 € » ou « la réponse : c’est à cause du coût du capital ».

- Le mélange des questions ne marche pas.

Blackboard permet aussi de mélanger l’ordre des questions, pour éviter la communication entre étudiant(e)s. Mais hélas, la pratique nous montre que certains étudiants sont très organisés : au lieu de demander « quelle est la réponse à la question 7 », ils demandent « réponse sur le cours du pétrole ? » – ainsi, peu importe que la question soit à un endroit différent dans l’examen. Certes, on peut bâtir un corpus de questions très large pour noyer les étudiant(e)s : par exemple 1 000 questions d’examen, dans lesquelles le système puisera au hasard 100 questions pour un(e) étudiant(e) donné(e). Mais cela pose plusieurs problèmes : d’abord, devoir rédiger un grand nombre de questions ; ensuite, s’assurer que les questions sont de même niveau de difficulté et donnent le même nombre de points – c’est très fastidieux. La seule possibilité – qui existe – serait non seulement de mettre les questions en ordre aléatoire, mais aussi d’interdire de revenir en arrière une fois qu’on a répondu à une question. Mais cela peut contrevenir à la loi n°1 : en effet, un(e) étudiant(e) non tricheur peut souhaiter revenir en arrière, car la question n°7 (par exemple) lui a fait penser à une meilleure solution pour la question n°3. Ce ne serait pas juste de l’empêcher de modifier une réponse avant l’heure finale de l’examen.

- La plupart des QCMs testent des connaissances, pas des capacités.

L’auteur de cet article a été confiné avec 5 jeunes qui poursuivent des études à distance, et il a donc pu apprécier les systèmes d’évaluation de différents cursus universitaires. La plupart du temps, les examens en ligne prennent la forme d’un QCM, et la plupart du temps, ce QCM teste des connaissances, et non des capacités. Les professeurs préviennent d’ailleurs leurs étudiants : « pour l’examen, il faut que vous connaissiez surtout les dates importantes et les grands noms des inventeurs ». Le QCM devient alors une épreuve de mémorisation et de vitesse : pour certains professeurs, proposer 100 questions pour 1 heure d’examen permet – selon eux – de discriminer suffisamment les étudiant(e)s. Mais est-ce que cela évalue leur apprentissage, ou simplement leur capacité à régurgiter rapidement des informations ? Certes, il y a des formations qui nécessitent d’apprendre par cœur (par exemple, en Anatomie), mais ces situations sont finalement rares : la plupart du temps, les cours demandent à démontrer une capacité à raisonner, s’exprimer et agir, et non pas à jouer simplement le rôle d’un chien savant.

- Le scoring des QCM soulève des problèmes.

Certains cursus ont la règle suivante : si l’étudiant a oublié ne serait-ce qu’une réponse juste, il a zéro à la question entière. Je considère cela comme une aberration. Si je coche 3 réponses sur les 4 réponses qui étaient justes, je devrais avoir droit aux ¾ des points, et non à zéro. Sinon, il n’y aura aucune discrimination entre l’étudiant qui a travaillé les ¾ de cette matière, et le paresseux qui n’a rien étudié – ce qui est profondément injuste. Heureusement, la plupart des systèmes d’examen proposent de donner des points partiels en fonction du nombre de réponses correctes de l’étudiant. Encore faut-il que le professeur (1) connaisse cette fonction, et surtout (2) souhaite effectivement l’appliquer.

Il y a aussi la question des points négatifs : une réponse fausse doit-elle diminuer la note à la question ? Imaginons une question avec réponses multiples (QRM) : il y a 5 réponses proposées, et le professeur a indiqué qu’il « peut y avoir » plus d’une réponse possible (sans indiquer le nombre de réponses correctes). Si le professeur commet l’erreur de ne pas mettre de points négatifs, alors l’étudiant n’a qu’à cocher les 5 réponses à chaque fois : il sera sûr de collecter tous les points. Il faut donc mettre des points négatifs pour les mauvaises réponses. Mais la question suivante est plus complexe : comment doivent être dosés ces points négatifs ? Si l’on coche l’intégralité des 5 réponses, doit-on obtenir un score de 0, un score moyen (par exemple 2,5/5) ou un score négatif (qui pénalisera alors le score global) ? Les avis divergent, et comme souvent, l’absence de réponse tranchée permet de mieux réfléchir à la question.

- Les réponses d’un QCM doivent être sans équivoque possible.

Le QCM a l’avantage d’un système automatisé : lire la question, cocher une ou plusieurs réponses, être noté automatiquement en conséquence. Mais cela nécessite de formuler des questions et des réponses sans aucune équivoque. Il n’y a aucune place pour la nuance, ou pour les finesses d’interprétation. C’est donc un exercice littéraire (et logique) assez astreignant que de rédiger un « bon » QCM. En pratique, je constate que même pour les questions les plus simples et les plus claires, certains étudiants arrivent à se triturer les méninges. Projettent-ils plus de difficultés que nécessaire ? Cherchent-ils la petite bête ? Souvent, derrière son apparente simplicité opérationnelle, le QCM souligne que ça n’est pas si simple de tester une connaissance de manière granulaire.

Quelques conseils issus de l’expérience

Tout démarre avec le QCM

Le QCM n’est pas le Diable quand on le regarde en détail. Il suffit de chercher à dépasser le stade « contrôle des connaissances » pour aborder le stade « test d’une compétence ». Voici quelques conseils issus de beaucoup d’essais-erreurs.

- Conseil n°1 : abandonner les QCM et ne plus faire que des QRM.

On se souvient que le QCM n’offre qu’une réponse possible, alors que le QRM peut proposer plusieurs réponses justes. Mon conseil : transformer tous ses QCM en QRM – même ceux qui n’ont qu’une seule réponse correcte – et ceci pour plusieurs raisons. Premièrement, il n’est pas nécessaire d’annoncer le nombre de bonnes réponses. Si on dit à l’étudiant qu’il n’y a qu’une réponse juste, il peut procéder par élimination, ou bien s’arrêter de réfléchir dès qu’il a identifié la bonne réponse, tandis qu’une phrase du type « cochez toutes les bonnes réponses » oblige à vraiment réfléchir à chaque possibilité. Deuxièmement, au moins sous BlackBoard, les QCM offrent des réponses « boutons radio » tandis que les QRM offrent des réponses « case à cocher », ce qui est au désavantage des QCM. En effet, imaginons la situation suivante : dans un QCM avec boutons radio (une seule réponse juste), l’étudiant choisit la réponse A. Mais après réflexion, l’étudiant n’est pas sûr, et il souhaite jouer la sécurité en ne répondant finalement pas à cette question. Eh bien avec des boutons radios, ce n’est pas possible d’annuler une réponse : à partir du moment où vous avez cliqué sur un bouton (réponse A), vous pouvez juste cliquer une autre réponse (réponse B, réponse C), mais pas dé-cliquer le tout. Or, si une réponse fausse occasionne des points négatifs, alors certains étudiants préfèreront ne pas répondre aux questions sur lesquelles ils ont des doutes. Cela ne sera possible qu’avec un QRM (toutes les cases peuvent être décochées) et pas avec un QCM auquel on a répondu (il reste toujours une réponse cliquée).

- Conseil n°2 : la réponse doit idéalement tester une compétence, pas une connaissance.

Un QCM / QRM n’est pas mauvais en soi. Il suffit de rédiger la question sous forme d’un problème à résoudre. Par exemple : « vous devez faire 100 g de chocolat blanc et 100 g de chocolat au lait. Vous disposez de 200 g de beurre de cacao, 100 g de sucre, 100 ml de lait, 200 g de cacao en poudre. Combien vous reste-t-il de cacao en poudre à la fin de la recette ? » Dans ce cas, on teste une capacité professionnelle de l’étudiant. C’est une évaluation plus subtile que de lui demander de cocher la bonne recette entre 4 réponses. Mais cela ne résout pas tous les problèmes de triche : en effet, une fois que l’étudiant a terminé le processus de résolution, il peut communiquer la réponse rapidement (« c’est 75 g de cacao »)

Les formules calculées

C’est une variante calculatoire de la question précédente, qui présente l’avantage de proposer des nombres tirés au hasard. Ainsi, un(e) étudiant(e) aura « vous devez faire 100 g de chocolat blanc et 100 g de chocolat au lait » tandis qu’un autre étudiant lira « vous devez faire 70 g de chocolat blanc et 120 g de chocolat au lait », et BlackBoard calcule à chaque fois la réponse correcte. Cela permet vraiment d’éviter la diffusion d’informations. En revanche, cela ne teste qu’une capacité à mémoriser – puis à appliquer – une formule, sans juger de la capacité d’interprétation du résultat. D’autre part, cela ne marche qu’avec des disciplines qui utilisent des formules ou des calculs.

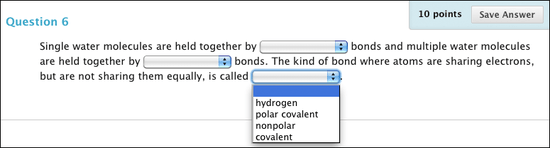

Les phrases à compléter

Ce sont mes questions favorites. Normalement, ce sont des outils pour vérifier la mémorisation, mais on peut détourner leur propos pour en faire de vrais outils de test de compétences.

- Conseil n°1. Éviter les champs à remplir, privilégier les menus déroulants.

Certaines phrases « à trous » proposent un champ de texte à remplir – c’est-à-dire que l’étudiant(e) tape la bonne réponse au clavier. Cela n’est pas souhaitable, car le logiciel ne reconnaît que les mots déclarés. Si la phrase est « Impossible n’est pas … », le correcteur aura déclaré « français » comme bonne réponse, mais peut-être pas « francais » sans cédille ou « Français » avec une majuscule. Il suffit alors d’une faute de typographie pour que la réponse soit considérée comme étant incorrecte, ce qui n’est pas juste, notamment vis-à-vis des étudiant(e)s dont le français n’est pas la langue natale. L’avantage des menus déroulants est qu’ils proposent une liste de termes à choisir, donc il n’y aura pas de problème de faute de frappe ou d’orthographe, voire de synonymes.

- Conseil n°2 : la réponse doit idéalement tester une compétence, pas une connaissance.

On réplique ici le même raisonnement que pour le QCM / QRM : rédiger la question sous forme d’un problème à résoudre. Mais ici, la phrase permet de valider un ensemble de notions. Si je prends l’exemple de l’analyse financière (une de mes matières), le problème prendra la forme suivante : « voici les comptes d’une société sur les 5 dernières années. Calculez la rentabilité des capitaux engagés (ROCE), décomposez la, puis retrouvez les éléments corrects dans la phrase suivante ».

La phrase offre alors des trous avec une liste déroulante, comme dans cet exemple : « La marge d’exploitation (augmente ; diminue ; reste stable ; décroît légèrement), et dans le même temps on assiste à une (hausse ; baisse ; stagnation) du BFR en jours de ventes ce qui, finalement, est plutôt (bon ; mauvais ; neutre) en ce qui concerne la rentabilité ».

Ce type de phrase nécessite donc que l’étudiante fasse des calculs ET pose un diagnostic avec des causes, des conséquences et un jugement de valeur sur la situation. Un avantage supplémentaire est qu’il peut y avoir plusieurs phrases : on pourrait même imaginer un paragraphe entier de diagnostic à formuler. Il y a néanmoins quelques limites à cet outil. D’une part, la rédaction des phrases à trous et surtout, le choix des termes dans la liste déroulante, doit à chaque fois ne donner qu’une solution possible. Il ne doit pas rester de place pour des interprétations différentes, ce qui conduit le plus souvent à sélectionner des cas de figures assez simples. D’autre part, cela ne prévient pas totalement la triche : il suffit qu’un(e) étudiant(e) ait fait les calculs pour transmettre la phrase correcte à ses camarades (« La marge d’exploitation augmente, et dans le même temps on assiste à une baisse du BFR en jours de ventes ce qui, finalement, est plutôt bon en ce qui concerne la rentabilité »).

La 5ème loi

Toutes les solutions mentionnées ci-dessus sont intéressantes, car non seulement elles offrent des possibilités bien supérieures au « simple » QCM, mais par-dessus tout, elles permettent de développer une réflexion sur ce que le professeur souhaite évaluer.

Il reste maintenant un aspect important : le feedback. Beaucoup d’étudiants demandent plus qu’une note : ils veulent comprendre ce qu’ils ont bien fait et ce qu’ils pourraient améliorer. Un score sur un QCM ne suffit donc pas : on revient à la tension entre automatisation de la notation (qui arrange le professeur), et personnalisation de l’évaluation (qui est la demande légitime de l’étudiant). On pourrait donc ajouter une loi n°5 : un examen final idéal devrait permettre à un(e) étudiant(e) d’apprendre de ses erreurs.

Conclusion

Si l’on revient à l’objectif, c’est-à-dire de prévenir la triche tout en restant dans le respect de la Loi n°1, aucune solution n’est fiable à 100%, car il suffit que les étudiant(e)s communiquent entre eux – et aucun système informatique ne peut couper tous les canaux d’information des étudiant(e)s à distance. En d’autres termes, même si les solutions évoquées ci-dessus offrent des avantages, aucune ne permet de respecter la loi n°4, c’est-à-dire d’envisager un examen sans surveillance. Pour avoir un examen sans surveillance, il faudrait que la transmission d’information ne serve à rien, donc qu’il y ait un examen différent pour chaque étudiant. Cela pose des problèmes évidents de temps, non seulement le temps de conception de multiples examens, mais aussi le temps de notation (car il n’y a pas d’économie d’échelle quand on doit noter des examens tous différents).

Notons que ce genre d’évaluation différenciée existe déjà : il s’agit des travaux individuels à rendre au cours du semestre. La solution serait alors d’oublier les examens finaux, pour rester focalisé sur du contrôle continu sous forme d’un contrôle individualisé des capacités. Si nous allons dans ce sens, il faudrait juste que les professeurs – et leurs institutions – acceptent le temps additionnel que cela représente dans le travail du professeur.

Enfin, si l’université ou l’école souhaitent absolument organiser des examens finaux, il faut noter qu’aucune solution d’examen à distance n’est véritablement fiable pour éviter la triche. La solution consiste alors à revenir aux examens en présentiel avec surveillance.